Η απόδοση της Nvidia GeFORCE GTX 680 αποκαλύπτεται

Οι επιδόσεις της GeFORCE GTX 680 αποκαλύφθηκαν πρόσφατα στο κινέζικο site HKEPC, ωστόσο αρκετοί κάνουν λόγο για... υπερβολές.

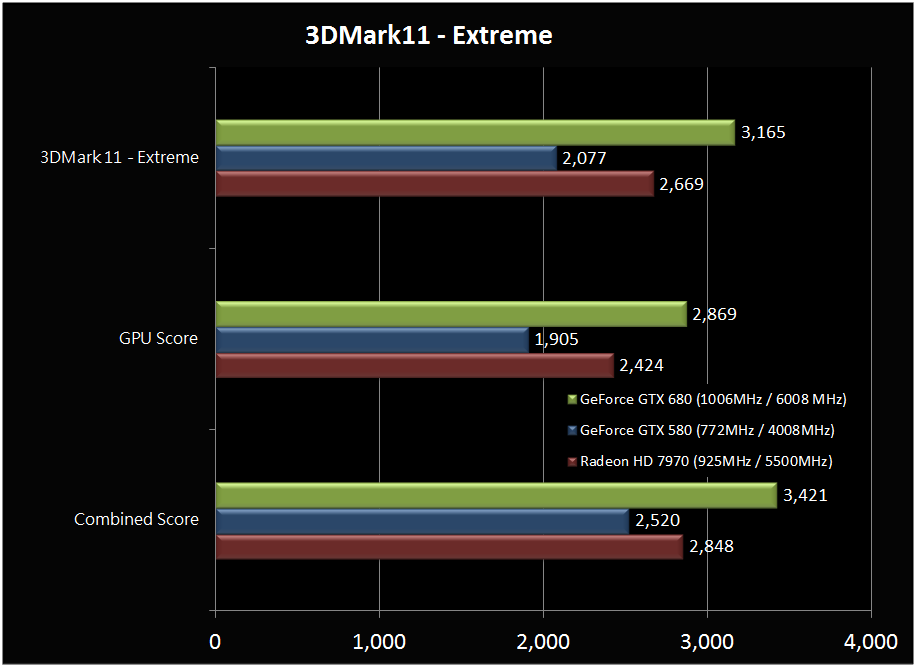

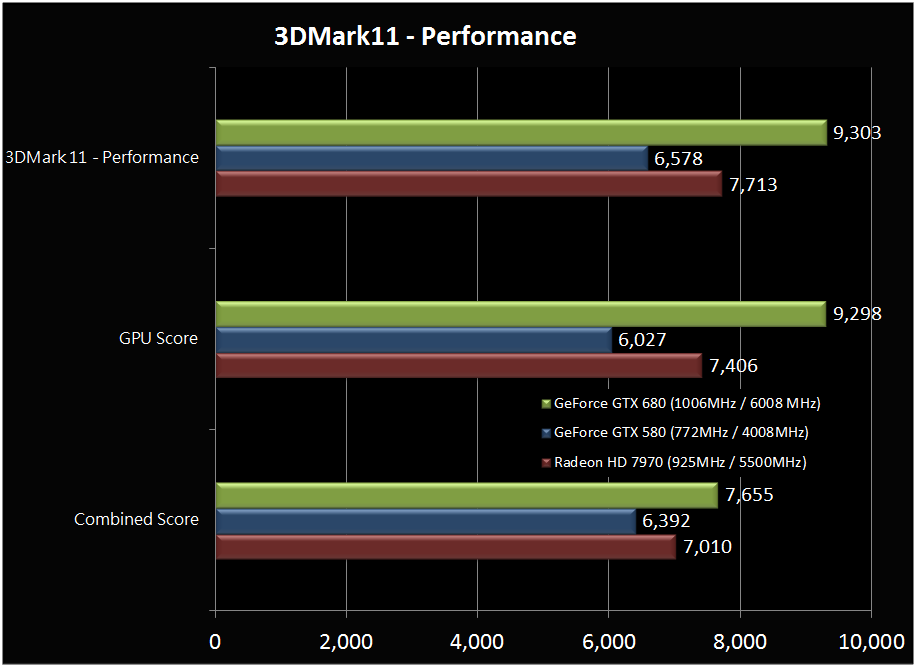

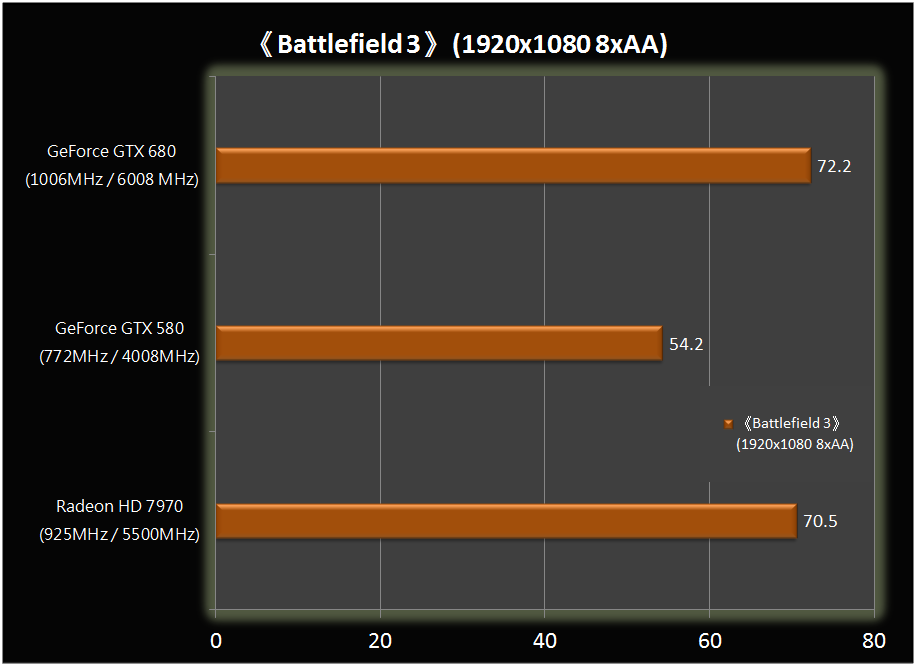

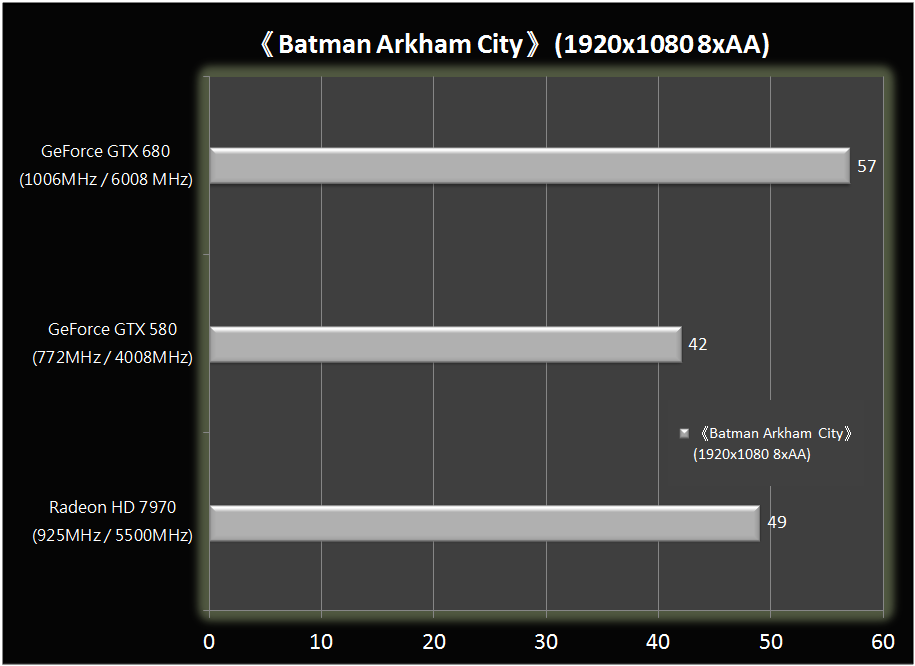

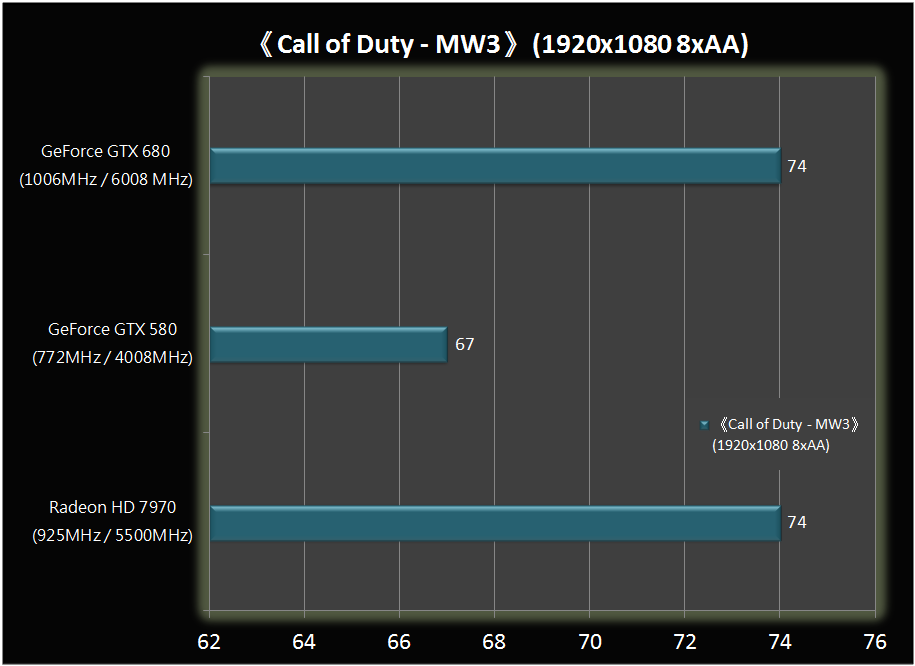

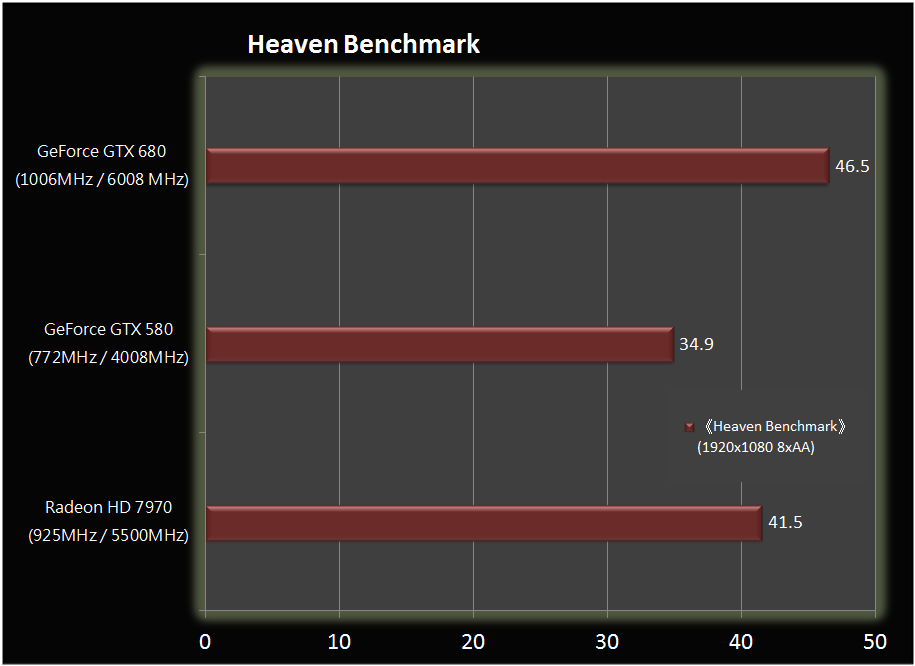

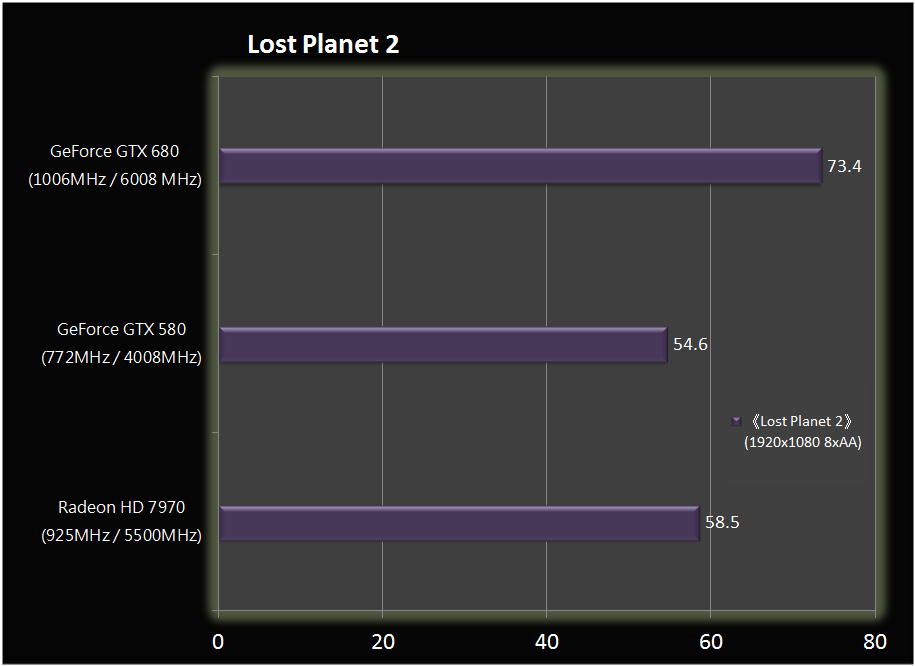

Η απόδοση της νέας GeFORCE GTX 680 δείχνει να είναι υψηλότερη της Radeon HD 7970 σχεδόν σε όλες τις περιπτώσεις και σε όλα τα benchmarks, ωστόσο φαίνεται να υπάρχει αντίλογος όσο αφορά στο τρόπο που πραγματοποιήθηκαν οι μετρήσεις.

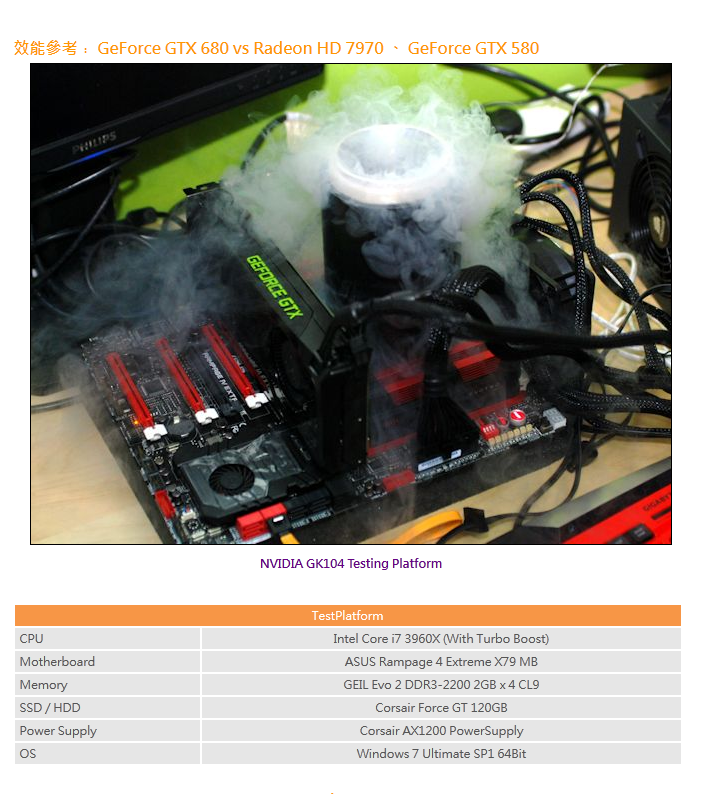

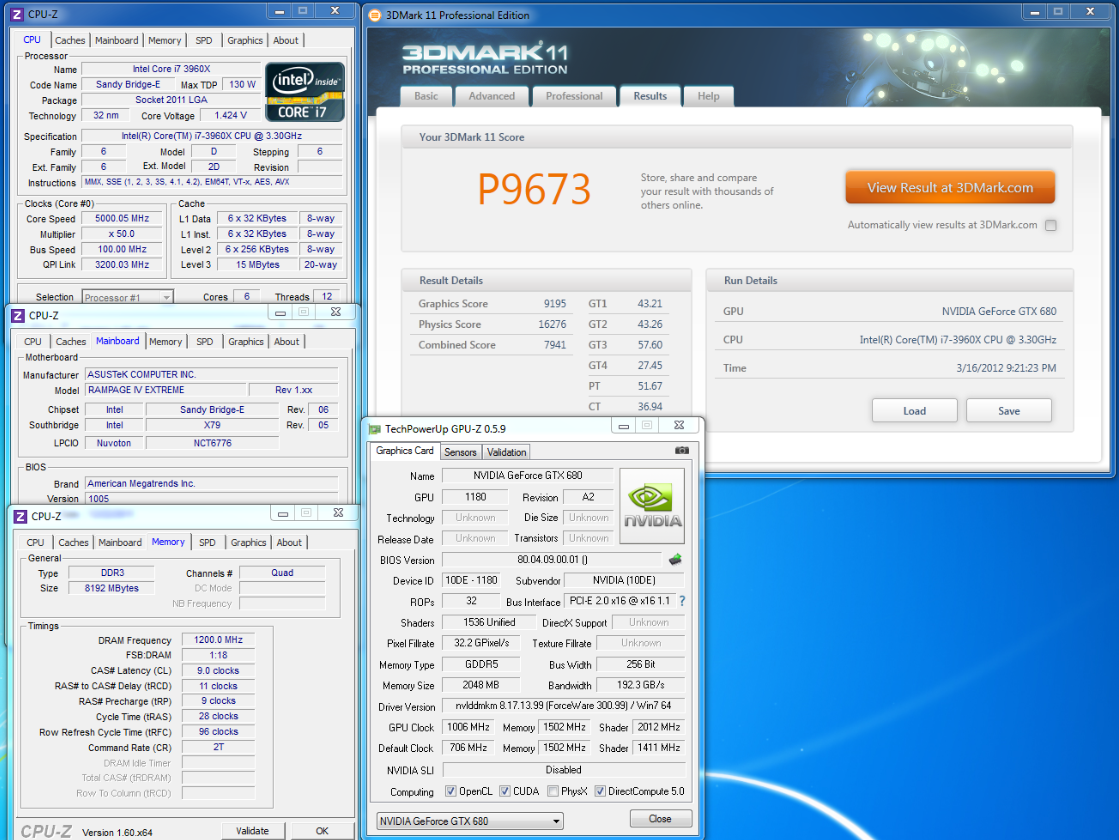

Το σύστημα που χρησιμοποιήθηκε είναι εξαιρετικό για να κάνει κάποιος μετρήσεις, με την έννοια ότι ο επεξεργαστής, ένας Intel Core i7-3960X Extreme Edition, χρονισμένος στα 5.0GHz αποκλείεται να "κρατάει πίσω" τις κάρτες γραφικών, αποτελώντας τροχοπέδη για τις επιδόσεις του συστήματος (bottleneck).

Το ίδιο μπορούμε να πούμε και για την μνήμη [8GB (2GB X 4) GeIL EVO 2 DDR3-2200 σε διάταξη quad-channel], την μητρική (ASUS Rampage IV Extreme) ή το τροφοδοτικό (Corsair AX1200W) και το SSD (Corsair Force GT 120GB).Το λειτουργικό σύστημα ήταν τα Windows 7 Ultimate SP1 64bit.

Οι μετρήσεις πραγματοποιήθηκαν χρησιμοποιώντας 8xAA και αναρωτιόμαστε: Γιατί δεν χρησιμοποιήθηκε Anisotropic Filtering; Επιπλέον τι είδους Anti-Aliasing είναι αυτό που χρησιμοποιήθηκε; Έχουμε να κάνουμε με MSAA ή με το νέου τύπου Anti-Aliasing που αναμένεται να παρουσιάσει η Nvidia, το TXAA (πρόκειται για ένα νέου τύπου αλγόριθμο, που βελτιώνει σημαντικά την ποιότητα απεικόνισης χωρίς να επιβαρύνεται ιδιαίτερα η απόδοση της κάρτας γραφικών);

Χρησιμοποιήθηκε όμοιου τύπου Anti-Aliasing και στις δύο κάρτες γραφικών, δηλαδή στην Nvidia GeFORCE GTX 680 και στην AMD Radeon HD 7970 ή όχι; Τι θα γινόταν αν και οι δύο κάρτες γραφικών είχαν την ίδια συχνότητα λειτουργίας σε επεξεργαστή και μνήμη; Γνωρίζουμε ότι η Radeon HD 7970 είναι δυνατόν να υπερχρονιστεί στα επίπεδα της GeFORCE GTX 680, δηλαδή περίπου 1.0GHz στον πυρήνα και 6.0GHz στην μνήμη.

Δεν αμφισβητούμε τα αποτελέσματα των μετρήσεων, δεν μπορούμε να είμαστε σίγουροι για οτιδήποτε, ωστόσο η άποψη μας είναι ότι οι μετρήσεις, γενικώς, όταν πραγματοποιούνται, θα πρέπει να απαντούν σε ερωτήματα, και όχι να δημιουργούν ερωτήματα στον χρήστη. Εσείς τι πιστεύετε;

Είσοδος

Συζητήσεις

-

5.253 απαντήσεις, τελευταία πριν 2 έτη 5 εβδομάδες

-

141 απαντήσεις, τελευταία πριν 5 έτη 32 εβδομάδες

-

287 απαντήσεις, τελευταία πριν 5 έτη 32 εβδομάδες

-

7.742 απαντήσεις, τελευταία πριν 5 έτη 32 εβδομάδες

-

0 απαντήσεις

-

0 απαντήσεις

-

0 απαντήσεις

-

0 απαντήσεις

-

0 απαντήσεις

-

0 απαντήσεις

- 1 of 226

- ››

Bits & Bytes

-

πριν 10 έτη 19 εβδομάδες

-

πριν 10 έτη 43 εβδομάδες

-

πριν 11 έτη 36 εβδομάδες

-

πριν 12 έτη 3 ημέρες

-

πριν 12 έτη 8 εβδομάδες

-

πριν 12 έτη 20 εβδομάδες

Έχεις δίκιο. Υπάρχουν πολλές

Έχεις δίκιο. Υπάρχουν πολλές παράμετροι που διαμορφώνουν ένα αποτέλεσμα.

ρε παιδια

ρε παιδια ειναι αληθεια αυτο τωρα ??... Ξενερωσα τωρα...

ολοι ξεραμε οτι ειναι η AMD 7970 η καλητερη και τωρα τι ειναι αυτα που κυκλοφορουν ?? αυτα τα χαρακτιριστικα ειναι αληθυνα ? http://videocardz.com/nvidia/geforce-600/geforce-gtx-680

και αν δουμε τα χαρακτιριστικα τις 7970 εχουν μεγαλη διαφορα με την 680 (δυχνει πολλη καλυτερη η 7970): http://videocardz.com/ati/radeon-7000/radeon-7970

πειτε μου την γνωμη σας..

Μη κολας στα χαρακτηριστικα,

Μη κολας στα χαρακτηριστικα, δεν λενε τιποτα απο μονα τους.

Ναι ειναι τα πραγματικα αυτα που δειχνουν (το 1GHz πρεπει να ειναι κατα πασα πιθανοτητα μεσω καποιας τεχνολογιας "Turbo", οπως εχουμε στους επεξεργαστες).

Αν ψαξετε λιγο καλυτερα τα αποτελεσματα θα διαπιστωσετε παντως πως η πραγματικη τους διαφορα, δεν ειναι μεγαλη.

Ας πουμε στο Battlefield 3 (οπου διαθετει αυτη τη στιγμη ισως την καλυτερη μηχανη γραφικων, απο αποψη δικαιας αξιοποιησης ολων των καρτων, χωρις προτιμησεις) η διαφορα ειναι πολυ μικρη. Επισης σε αλλες μετρησεις που εγιναν, οταν η HD 7970 ερχεται στα ιδια Hz με την GTX 680 σε πυρηνα και μνημη οι διαφορες σχεδον εξαλειφονται.

Οταν βγουν τα Reviews στις 22 το μηνα θα μαθουμε ολη την αληθεια...

τοτε ανυπομωνω

τοτε ανυπομωνω να βγουν τα reviews για να μαθουμε την αληθεια...

γιατι απο οτι βλέπω η AMD 7970 εχει ολα τις τα χαρακτιρηστικα πιο ανεβασμενα απο οτι η 680..

ΑΜD 7970

CORE CLOCK: 925 MHz

MEMORY CLOCK: 1375 MHz (5.5GHz)

MEMORY BANDWIDTH: 264 GB/sec

MEMORY SIZE: 3072 MB

MEMORY TYPE: GDDR5

MEMORY BUS TYPE: 384 bit

FRAGMENT PIPELINES: 2048

TEXTURE UNITS: 128

RASTER: 32

vs

GeForce 680

CORE CLOCK: 705 MHz

MEMORY CLOCK: 1500 MHz (6 GHz)

MEMORY BANDWIDTH: 192 GB/sec

MEMORY SIZE: 2GB

MEMORY TYPE: GDDR5

MEMORY BUS TYPE: 64×4 (256 bit)

FRAGMENT PIPELINES: 1536

TMU: 128

ROP: 32

πως γίνεται να ειναι καλυτερη η 680? ας μου εξηγησει καποιος να καταλαβω.. δηλαδή η 680 ειναι καλυτερη μονο και μονο επιδη εχει τον πυρηνα τις χρονισμενο στο 1GHZ με αυτη την καινουρια τεχνολογια και την μνημη της στα 6 GHZ ??

ειδικα το memmory bandwidth ειναι αρκετα υψυλοτερο..

(τα χαρακτηρηστικα των καρτων τα βρηκα εδω:www.videocardz.com)

Και σου ξαναλεω πως δεν θα

Και σου ξαναλεω πως δεν θα πρεπει να στεκεσαι στα χαρακτηριστικα και μονο. Να σου φερω ενα παραδειγμα?

HD 6970 με 1536 Cores, 880MHz και μνημες 5.5GHz

vs

GTX 580 με 512 Cores, 772MHz και μνημες 4GHz

Η AMD δεν φαινεται αρκετα ανωτερη? Και ομως δεν ειναι, χανει περιπου 15% απο την Nvidia. Το κλειδι στην ολη υποθεση ειναι η αρχιτεκτονικη (πως ειναι σχεδιασμενος) του πυρηνα.

Τα 512 της Nvidia ειναι πιο "ισχυρα" απο τα 1536 της AMD. Το ιδιο ισχυει και εδω, απλα η Nvidia ακολουθησε καπως την λογικη της AMD ετσι ωστε να βγαλει μικροτερο, λιγοτερο κοστοβορο και πιο αποδοτικο πυρηνα.

Το μεγαλυτερο memory bandwidth (και η ποσοτητα της μνημης) της AMD θα την βοηθησουν μονο σε υψηλες αναλυσεις, σε multi-monitor setup αλλα δεν θα τις δωσουν frames, απλα θα την βοηθησουν να μη τα χασει λογο κοφτη.

πωω

πωωω ειναι λιγο περιπλοκο...

δηλαδη η mars 2 http://rog.asus.com/graphics-card/mars-ii/mars-ii-2dis-3gd5/ πως θα παει...

οταν λες η nVidia ακολουθησε τι λογική της AMD ?

ΣΕ ΕΥΧΑΡΙΣΤΩ ΠΟΛΛΗ ΓΙΑ ΤΟ ΕΝΔΙΑΦΕΡΟΝ ΣΟΥ..

Την λογικη των μικροτερων,

Την λογικη των μικροτερων, πιο αδυμανων αλλα περισσοτερων Cores ετσι ωστε και το αποτελεσμα (πυρηνας) να εχει μικροτερες διαστασεις, μικροτερη καταναλωση αλλα λογο της ποσοτητας να μην υπολειπεται σε επιδοσεις.

Αυτη την τακτικη χρησιμοποιει η AMD σχεδον απο την αρχη που μπηκε στα Stream Processors (Radeon HD 2XXX). Και ετσι σιγα-σιγα μπορεσε να ανακτησει τα ποσοστα της στην αγορα και πλεον να ξεπερνα την Nvidia. Σε απολυτες επιδοσεις ηταν πιο πισω αλλα συνεφερε τον καταναλωτη μιας και πουλαγε πιο φθηνο προιον.

Και επειδη η Nvidia ειδε που παει το πραγμα πλεον ακολουθει παρομοια τακτικη ετσι ωστε να την ανταγωνιζεται στα ισια.

δηλαδη απο δω και

δηλαδη απο δω και περα η nvidia θα χρησημοποιή πολλους cores σαν την AMD ?? και κατι αλλο..

απο το παραδειγμα που μου εδωσες

(HD 6970 με 1536 Cores, 880MHz και μνημες 5.5GHz

vs

GTX 580 με 512 Cores, 772MHz και μνημες 4GHz) ηθελες να με δωσεις να καταλαβω οτι παιζει ρολο η αρχιτεκτονικη μιας GPU, αυτο το καταλαβα..

δηλαδη η 680 που χρησημοποιη 1500 cores ειναι πολλή καλυτερη απο την 580 που εχει 512 cores ?

αλλά κυριως αυτο που δεν καταλαβαίνω και το εχω πολλη μεγαλη απορια ειναι αυτα τα 1500 cores τις 680 ειναι φτιαγμενα με την τακτική που χρησημοποιη η AMD η ειναι αυτο που με ειπες πιο πανω "πιο ισχυρά" ?

δεν ξερω αν καταλαβες τι θελω να ρωτησω..

επισης η nvidia χρησημοποιη και turbo boost μηπως για αυτο ειναι πιο γρηγορη η nvidia ?? και επισης χρησημοποιη και το νεο ειδος ΑΑ που δεν ζωριζει πολυ την καρτα, μπορει να ευθηνεται και αυτο επισης..

(ΞΕΡΩ ΕΙΝΑΙ ΠΟΛΛΑ ΑΥΤΑ ΠΟΥ ΣΕ ΡΩΤΑΩ ΚΑΙ ΣΑΣ ΚΟΥΡΑΖΩ, ΑΛΛΑ ΑΥΤΑ ΕΙΝΑΙ ΤΑ ΕΡΩΤΗΜΑΤΑ ΠΟΥ ΜΟΥ ΔΗΜΙΟΥΡΓΗΘΗΚΑΝ ΚΑΙ ΘΕΛΩ ΠΟΛΥ ΝΑ ΜΑΘΩ)

ΣΕ ΕΥΧΑΡΙΣΤΩ ΠΟΛΥ ΓΙΑ ΤΗΝ ΚΑΤΑΝΟΗΣΗ...

θα μπορεσει να

θα μπορεσει να μου λυσει καποιος τις απορίες ?

Υπάρχουν σημαντικές διαφορές

Υπάρχουν σημαντικές διαφορές στην "προοπτική" που έχει σχεδιάσει κάθε εταιρεία τους επεξεργαστές γραφικών τους. Κάνουν χρήση διαφορετικής αρχιτεκτονικής, και ενώ ορισμένες εργασίες στο pipeline είναι ουσιαστικά ίδιες, υπάρχουν άλλες τόσες που είναι εντελώς διαφορετικές στον τρόπο που χειρίζονται τα δεδομένα. Έχουν τον ίδιο στόχο (performance/watt) αλλά χρησιμοποιούν διαφορετική σχεδίαση για να φτάσουν εκεί.

Γιατί ας πούμε ένας επεξεργαστής Core i7 είναι πιο γρήγορος από έναν Phenom, αν έχουν τον ίδιο αριθμό πυρήνων και όμοια συχνότητα λειτουργίας; Κάπως έτσι είναι και με τις κάρτες γραφικών. Τα δυο μεγέθη είναι ασύγκριτα μεταξύ τους, επειδή οι αρχιτεκτονική είναι διαφορετική αλλά και επειδή οι εταιρείες τυγχάνει να "μετρούν" διαφορετικά τα στοιχεία του πυρήνα των chip τους.

Με απλά λόγια η AMD, δείχνει να "μετράει" πιο απλά στοιχεία σε σχέση με την Nvidia που μετράει πιο "πολύπλοκα" στοιχεία.

Εντωμεταξύ έχουμε και την συχνότητα λειτουργίας των "shader units", που στην περίπτωση της Nvidia, ορισμένες φορές έχουν διπλάσια συχνότητα λειτουργίας.

Η ΑMD χρησιμοποιεί αρχιτεκτονική VLIW (Very Long Instruction Word) ενώ η Nvidia, δεν έχει γνωστοποιήσει το σύνολο των σετ εντολών που χρησιμοποιεί, ωστόσο περιγράφει την αρχιτεκτονική της ως "scalar" [γνωρίζουμε ότι χρησιμοποιούνται εντολές τύπου SIMD πάντως (Simple Instruction Multiple Data) και MIMD (Multiple Instruction, Multiple Data)]

Η Nvidia στην τελευταία γενιά GK104 χρησιμοποιεί διαφορετικού τύπου Streaming Multiprocessors (στην προηγούμενη γενιά είχαν την ονομασία SM και σήμερα λέγονται SMX) με τετραπλάσιο αριθμό πυρήνων CUDA ή shaders αν θέλεις. Και αυτό κατά μεγάλο ποσοστό οφείλεται στην κλίμακα ολοκλήρωσης 22nm. Έτσι, ενώ η GF104 της προηγούμενης γενιάς είχε 48 πυρήνες CUDA ανά SM, η νέα GK104 διαθέτει 192 πυρήνες CUDA. Αυτό όμως δεν σημαίνει ότι δεν έχουν γίνει και συμβιβασμοί, ώστε να επιτευχθεί μία ισορροπία ανάμεσα στο μέγεθος του die, στην απόδοση, στην θερμοκρασία λειτουργίας και στην κατανάλωση χοντρικά. Στην πρώτη περίπτωση είχαν διπλάσια ταχύτητα από τον πυρήνα, ενώ σήμερα τρέχουν στην ίδια συχνότητα με τον πυρήνα....

τέλος πάντων, εκεί που θέλω να καταλήξω, είναι ότι οι δύο εταιρείες ακολουθούν διαφορετική λογική στην σχεδίαση των chip τους.

Αν σε ενδιαφέρει η αρχιτεκτονική γενικώς, τότε σου προτείνω να διαβάσεις το Beyond the valley of the lost processors.